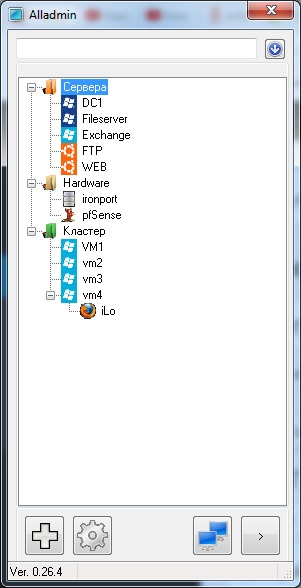

Данная статья носит ознакомительных характер и не претендует на высокие знания в области HP коммутаторов. Все настройки и догадки выстроены на основе официальной документации hp57хх

Нам пришло оборудование: два 42 портовых HP коммутатора 5700, с двумя SFPQ+ портами на каждом.

Первая наша задача это собрать из данных коммутаторов единый стэк, в технологии HP это называется IRF fabric (IRF пространство).

Стэк — это соединение двух или более физических коммутаторов в единый логический коммутатор, для увеличения количества портов, а так же для управляемости.

При первом включении он пытается получить адрес по DHCP и как то сам сконфигурироваться, для отмены сего действия нажимаем CTR+Z и идем далее.

Первое что меня встречает это надпись вида

HPE DEV/1/FAN_DIRECTION_NOT_PREFERRED: Fan 1 airflow direction is not preferred on slot 1, please check it.

HPE DEV/1/FAN_DIRECTION_NOT_PREFERRED: Fan 2 airflow direction is not preferred on slot 1, please check it.

Не сильно углублялся в данную тематику, но кажется что на передней и задней стороне коммутатор стоят датчики тепла и если поток в задней части холоднее чем в передней то надо поменять направления потока воздуха. Но по факту, когда я сменил эти настройки, ни чего не изменилось кроме исчезновения предупреждения.

И так, для начала посмотрим что там установлено, для этого зайдем в режим System view (по аналогии configure terminal у Cisco)

Далее смотрим настройки fan.

[HPE]display fan

Slot 1:

Fan 1:

State : FanDirectionFault

Airflow Direction: Port-to-power

Prefer Airflow Direction: Power-to-port

Fan 2:

State : FanDirectionFault

Airflow Direction: Port-to-power

Prefer Airflow Direction: Power-to-port

Посмотрели? Меняем:

fan prefer-direction slot 1 port-to-power

Смотрим что поменялось

[HPE]display fan

Slot 1:

Fan 1:

State : Normal

Airflow Direction: Port-to-power

Prefer Airflow Direction: Port-to-power

Fan 2:

State : Normal

Airflow Direction: Port-to-power

Prefer Airflow Direction: Port-to-power

Изменился параметр Prefer Airflow Direction.

Назначение идентификатора участника каждому устройству группы IRF

Нам требуется объединить два коммутатора в единый стек. В документации это называется IRF Domain. Объединять я буду через интерфейсы QSFP+.

Первый наш шаг заходим в режим system view (если мы еще не в нем).

Смотрим текущие настройки IRF (на первом и втором коммутаторе)

Первый

[HPE]display irf configuration

MemberID NewID IRF-Port1 IRF-Port2

1 1 disable disable

Второй

[HPE]display irf configuration

MemberID NewID IRF-Port1 IRF-Port2

1 1 disable disable

Как видим, оба участника имеют одинаковый MemberID. Данное обстоятельство не позволяет формировать IRF link, поэтому зададим на втором коммутаторе MemberID = 2.

[HPE]irf member 1 renumber 2

Смотрим результат

[HPE]display irf configuration

MemberID NewID IRF-Port1 IRF-Port2

1 2 disable disable

Изменения вступят в силу только после перезагрузки устройства. Сохраняем текущую конфигурацию на обоих коммутаторах.

[HPE]save

The current configuration will be written to the device. Are you sure? [Y/N]:y

Please input the file name(*.cfg)[flash:/startup.cfg]

(To leave the existing filename unchanged, press the enter key):

Validating file. Please wait...

Saved the current configuration to mainboard device successfully.

Перезагружаем второй коммутатор. Для этого выйдем на уровень ниже

Настройка приоритезации в группе IRF.

Данная настройка будет влиять на выбора мастера группы IRF если основной мастер «потерялся».

У кого выше приоритет, тот и будет мастером.

При потере основного мастера, смена мастера происходит не сразу.

По умолчанию на всех коммутаторах приоритет стоит =1.

Меняем на втором коммутаторе на 2.

<HPE>system-view

[HPE]irf member 2 priority 2

The device is not in the current IRF.

Как понятно из сообщения, устройство не является членом IRF.

Построение физических интефейсов в IRF порты.

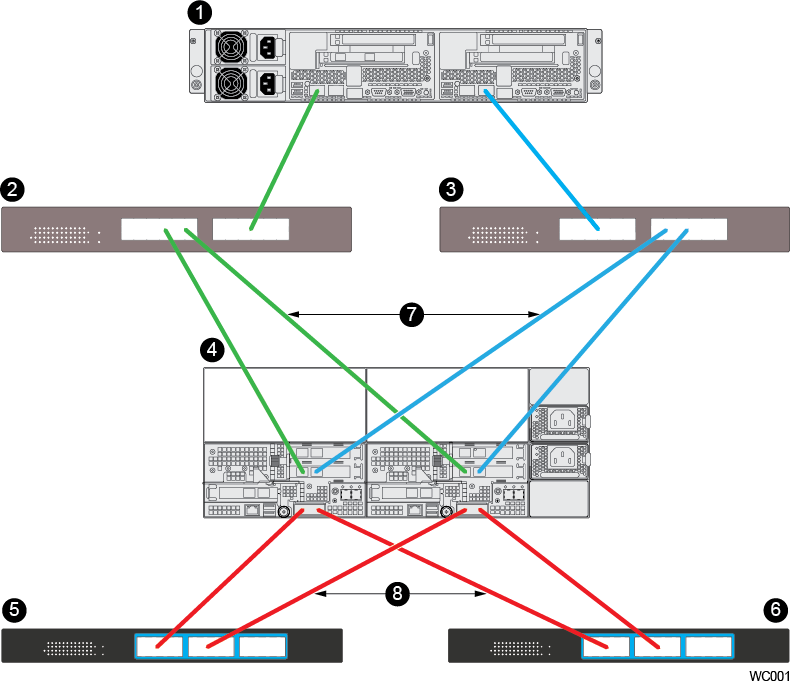

Немного теории. Следуя из мануалов HP устройства имеют два виртуальных IRF порта, называемые n/1 и n/2, где n это member-id. А 1 и 2 созданы для «кольцевания», т.е. 1 — это образно говоря исходящий порт, а 2- это входящий порт. Еще проще говоря два коммутатор должны втыкаться кросированно из первого IRF порта во второй IRF порт. Т.е. первый IRF порт коммутатор должен втыкаться во второй IRF порт второго коммутатора. А вот если мы хотим подключить еще и третий коммутатор, то первый IRF порт второго коммутатора подключаем ко второму IRF порту третьего коммутатора, ну а чтобы вообще все красиво было и в кольцо, то первый IRF порт третьего коммутатора подключаем во второй IRF порт первого коммутатора.

Внимание: нельзя включать оба IRF порта одного устройства в IRF порта другого устройства. Т.е. 1/1 к 2/2 можно , а вот еще добавить 1/2 к 2/1 уже нельзя.

Тезисы:

По умолчанию ни один физический порт не привязан к IRF порту

На один IRF порт может быть назначено до 4х физических интерфейсов.

Для настройки должны выполняться следующие условия:

Настраиваемые порты IRF должны быть выключены.

Для работы возьмем сразу группу интрейфейсов. У нас это SFPQ+ 41 и 42 порт

На первом коммутаторе

[HPE]interface range FortyGigE 1/0/41 to FortyGigE 1/0/42

На втором коммутаторе

[HPE]interface range FortyGigE 2/0/41 to FortyGigE 2/0/42

Выключаем их

На первом коммутаторе выходим на уровень выше и заходим в режим IRF указывая первым параметром member-id вторым port-number. Т.е. настраиваем IRF n/1.

[HPE-if-range]quit

[HPE]irf-port 1/1

Добавляем наши SFPQ+ порты в IRF порт n/1 на первом коммутаторе

[HPE-irf-port1/1]port group interface FortyGigE 1/0/41

You must perform the following tasks for a successful IRF setup:

Save the configuration after completing IRF configuration.

Execute the "irf-port-configuration active" command to activate the IRF ports.

[HPE-irf-port1/1]port group interface FortyGigE 1/0/42

На втором коммутаторе уже делаем настройку «принимающего» порта IRF n/2

[HPE-if-range]quit

[HPE]irf-port 2/2

[HPE-irf-port2/2]port group interface FortyGigE 2/0/41

You must perform the following tasks for a successful IRF setup:

Save the configuration after completing IRF configuration.

Execute the "irf-port-configuration active" command to activate the IRF ports.

[HPE-irf-port2/2]port group interface FortyGigE 2/0/42

Включаем интерфейсы на первом коммутаторе

[HPE-irf-port1/1]quit

[HPE]interface range FortyGigE 1/0/41 to FortyGigE 1/0/42

[HPE-if-range]undo shutdown

На втором коммутаторе

[HPE-irf-port1/1]quit

[HPE]interface range FortyGigE 2/0/41 to FortyGigE 2/0/42

[HPE-if-range]undo shutdown

После включения сразу появиться сообщение вида на первом

[HPE-if-range]%Jan 12 22:56:06:483 2011 HPE IFNET/3/PHY_UPDOWN: FortyGigE1/0/41 link status is up.

%Jan 12 22:56:06:484 2011 HPE IFNET/5/LINK_UPDOWN: Line protocol on the interface FortyGigE1/0/41 is up.

%Jan 12 22:56:06:494 2011 HPE IFNET/3/PHY_UPDOWN: FortyGigE1/0/42 link status is up.

%Jan 12 22:56:06:496 2011 HPE IFNET/5/LINK_UPDOWN: Line protocol on the interface FortyGigE1/0/42 is up.

%Jan 12 22:56:06:523 2011 HPE LLDP/6/LLDP_CREATE_NEIGHBOR: Nearest bridge agent new neighbor created on Port FortyGigE1/0/42 (IfIndex 42), Chassis ID is ec9b-8bc7-75d3, Port ID is FortyGigE2/0/42.

%Jan 12 22:56:07:690 2011 HPE LLDP/6/LLDP_CREATE_NEIGHBOR: Nearest bridge agent new neighbor created on Port FortyGigE1/0/41 (IfIndex 41), Chassis ID is ec9b-8bc7-75d3, Port ID is FortyGigE2/0/41..

На втором

[HPE]%Jan 12 22:55:17:965 2011 HPE IFNET/3/PHY_UPDOWN: FortyGigE2/0/41 link status is up.

%Jan 12 22:55:17:967 2011 HPE IFNET/5/LINK_UPDOWN: Line protocol on the interface FortyGigE2/0/41 is up.

%Jan 12 22:55:18:028 2011 HPE LLDP/6/LLDP_CREATE_NEIGHBOR: Nearest bridge agent new neighbor created on Port FortyGigE2/0/41 (IfIndex 246), Chassis ID is ec9b-8bc6-183e, Port ID is FortyGigE1/0/41.

%Jan 12 22:55:18:058 2011 HPE IFNET/3/PHY_UPDOWN: FortyGigE2/0/42 link status is up.

%Jan 12 22:55:18:060 2011 HPE IFNET/5/LINK_UPDOWN: Line protocol on the interface FortyGigE2/0/42 is up.

%Jan 12 22:55:19:824 2011 HPE LLDP/6/LLDP_CREATE_NEIGHBOR: Nearest bridge agent new neighbor created on Port FortyGigE2/0/42 (IfIndex 247), Chassis ID is ec9b-8bc6-183e, Port ID is FortyGigE1/0/42.

Т.е. линки поднялись.

Сохраняем наши изменения и активируем наши настройки IRF портов на обоих коммутаторах.

Вот ту вышел косямба, я только не понял из за чего. Толи из за того что я сначала активировал на первом потом на втором, то ли может быть еще из за чего ни будь. Во всяком случае надо попробовать сначала активировать на первом и подождать. Должен перезагрузиться второй, т.е. подчиненный, мастер не перезагружается.

[HPE-if-range]quit

[HPE]save

[HPE]irf-port-configuration active

Стэк нормального курильщика

[HPE]display irf

MemberID Role Priority CPU-Mac Description

*+1 Master 1 00e0-fc0f-8c02 ---

2 Standby 1 00e0-fc0f-8c03 ---

--------------------------------------------------

* indicates the device is the master.

+ indicates the device through which the user logs in.

The bridge MAC of the IRF is: ec9b-8bc6-183e

Auto upgrade : yes

Mac persistent : always

Domain ID : 0

IRF mode : normal

[HPE]display irf topolog

Topology Info

-------------------------------------------------------------------------

IRF-Port1 IRF-Port2

MemberID Link neighbor Link neighbor Belong To

2 DIS --- UP 1 00e0-fc0f-8c02

1 UP 2 DIS --- 00e0-fc0f-8c02

Настройка постоянства MAC IRF структуры

По умолчанию IRF fabirc использует мак адрес мастера для IRF-моста, LACP например использует данный MAC для идентификации структуры IRF. Поэтому может возникнуть ситуация когда мастер уходит, выбирается другой мастер и соответственно произойдет смена МАК адреса моста IRF, что приведет к кратковременному нарушению трафика, чтобы этого не произошло или произошло, есть несколько режимов:

irf mac-address persistent timer — МАК адрес моста остается неизменным в течении 6 минут, на случай если оборудование было переазгружено, отключено и т.д., а потом вернулось обратно в рабочее состояние.

irf mac-address persistent always— МАК адрес моста не изменяется после того как уходит владелец. Но тут есть нюанс, если данный мак будет использоваться в другой сети IRF (потому что данное устройство стало там мастером), то трафик не будет ходить. В нашем случае это не страшно.

undo irf mac-address persistent — моментальная смена МАК адреса моста после ухода владельца.

В официально документации есть еще и рекомендации когда какой режим выбирать.

В нашем случае подходит режим irf mac-address persistent always. Делаем

<HPE>system-view

[HPE]irf mac-address persistent always

В этой статье все.

По итогу мы имеем стэк из двух коммутаторов соединенный двумя DAC кабелями через SFPQ+ порты. Общая скорость должна быть 80 Гигабит/c.

Так же есть авто-балансировка загрузки IRF линков по МАК адресам + отказоустойчивая схема, т.е. если один из IRF линков рвется, то весь трафик переключается на резервный канал.